Les différents moteurs font des compromis différents. Vous voulez celui qui correspond à votre trafic, à votre matériel et au temps que vous pouvez consacrer au réglage. Ces moteurs sont des bibliothèques et des boîtes à outils spécialisées créées et développées par des organisations et des groupes de recherche de premier plan. vLLM et TGI sont des bibliothèques créées pour une inférence LLM efficace. Voici une comparaison en anglais clair pour vous aider à faire votre choix.

Essayez Compute dès aujourd'hui

Si vous souhaitez un point de terminaison dédié avec une API compatible avec OpenAI, vous pouvez lancer un VllM serveur sur Calculer en quelques minutes. vLLM est une bibliothèque développée à l'UC Berkeley. Choisissez une région, choisissez le matériel et obtenez une URL HTTPS que vous contrôlez.

Présentation des moteurs d'inférence

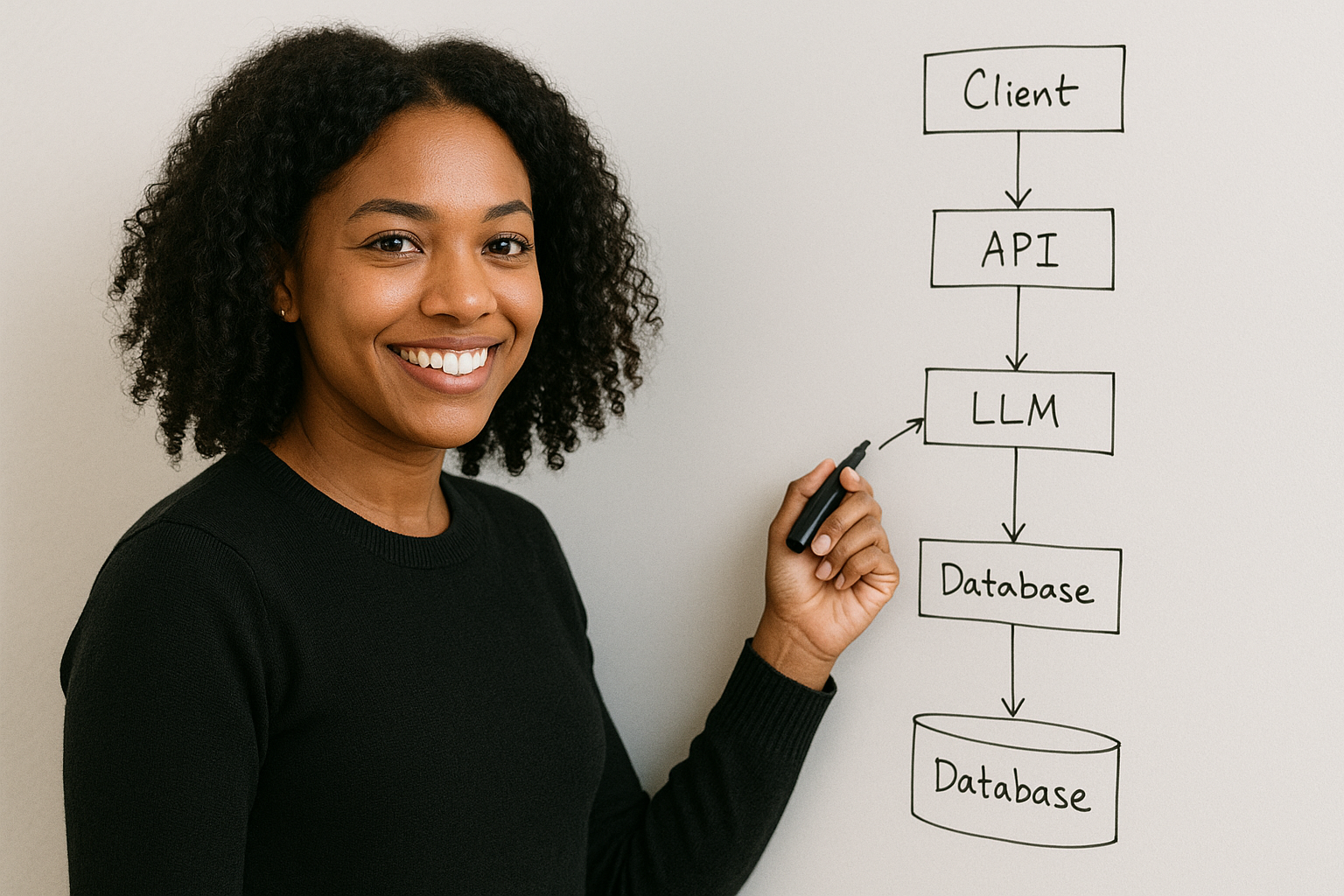

Les moteurs d'inférence font le gros du travail lorsque vous utilisez de grands modèles de langage en production. Ils sont conçus pour accélérer la génération de texte, utiliser judicieusement la mémoire et tirer le meilleur parti de votre matériel. Vous serez confronté à de véritables défis : des temps de réponse lents, une mémoire GPU qui se remplit rapidement et un trafic qui augmente sans avertissement. Des outils tels que TensorRT-LLM, vLLM et Hugging Face TGI s'attaquent à ces problèmes de front. Ils apportent des fonctionnalités telles que le traitement par lots continu, l'inférence distribuée et le parallélisme tensoriel qui fonctionnent réellement. Les phrases courtes permettent de faire avancer les choses. Ces optimisations vous permettent de servir les LLM sans les maux de tête habituels, tout en garantissant des réponses rapides et un débit élevé même en cas de pic de demande. Choisissez le bon moteur d'inférence et vous pourrez déployer de grands modèles linguistiques qui fonctionnent bien sous pression, offrant aux utilisateurs la génération de texte rapide et fiable à laquelle ils s'attendent.

Comprendre les grands modèles de langage

Les grands modèles linguistiques vous permettent de générer du texte comme un humain pour d'innombrables utilisations : chatbots, assistants virtuels, création de code, traduction. Ils sont impressionnants car ils comprennent le contexte et réagissent naturellement, grâce à des milliards de paramètres qui fonctionnent ensemble. Mais voici le défi que vous devez relever : ces modèles exigent une puissance de calcul et une mémoire importantes. Les déployer n'est pas simple. C'est là que les moteurs d'inférence entrent en jeu. Ils réduisent le poids des modèles, réduisent l'utilisation de la mémoire et accélèrent les réponses. Lorsque vous comprenez ce que les LLM peuvent faire et quels sont leurs coûts d'exploitation, vous pouvez choisir le moteur d'inférence et le configurer adaptés à vos besoins. Cela signifie une génération de texte fluide et rapide qui ne bloquera pas votre infrastructure et ne fera pas exploser votre budget.

Comparaison rapide

VLLM en pratique

- Pourquoi les équipes le choisissent : Serveur HTTP compatible OpenAI, forte simultanéité, valeurs par défaut sensibles et nouvel algorithme d'attention (PagedAttention) qui améliore le débit et l'efficacité. vLLM est également choisi pour sa vitesse de décodage élevée, ce qui le rend idéal pour l'inférence de génération de texte à faible latence et à haut débit.

- Ce que vous réglez : nombre maximum de jetons (nombre de jetons traités par demande), longueur du contexte, limites de planification, formes de lots et mise en cache kv pour une gestion optimisée de la mémoire et de l'état des jetons.

- Où il convient : Points de terminaison dédiés aux applications dont le trafic est constant ou élevé et pour lesquelles vous souhaitez des performances prévisibles. vLLM est un moteur d'inférence LLM conçu pour servir les LLM en production, prenant en charge le déploiement et la diffusion efficaces de modèles linguistiques volumineux, avec une prise en charge optimisée de l'inférence de génération de texte et de plusieurs GPU.

Le TGI en pratique

- Pourquoi les équipes le choisissent : Le TGI (Text Generation Inference) est conçu pour les LLM et propose des outils matures dans l'écosystème Hugging Face, une documentation complète, une facilité d'utilisation et une bonne couverture des modèles.

- Ce que vous réglez : tailles de lots, paramètres du tokenizer et indicateurs spécifiques au modèle.

- Où il convient : Le TGI fait partie d'une boîte à outils plus large pour le déploiement et la gestion des LLM, ce qui le rend idéal pour les équipes investissant dans les pipelines HF et les outils d'inférence.

Tensorrt‑LLM en pratique

TensorRT-LLM, développé par NVIDIA, fait partie de la boîte à outils d'inférence de NVIDIA pour le déploiement et l'optimisation de grands modèles de langage (LLM).

- Pourquoi les équipes le choisissent : Des performances optimales sur du matériel NVIDIA lorsque vous pouvez investir dans la création de moteurs et dans des optimisations statiques. Les équipes bénéficient également d'algorithmes d'attention avancés, tels que PagedAttention, qui améliorent le débit et l'efficacité de l'inférence LLM.

- Ce que vous réglez : précision, optimisations graphiques, moteurs par modèle, scripts de déploiement et mise en cache kv pour améliorer l'utilisation du GPU et réduire la latence d'inférence.

- Où il convient : Chemins critiques en termes de latence sur les modèles et les GPU pris en charge, en particulier lors du déploiement avec Triton Inference Server. Les limites incluent la nécessité de compiler les modèles, le recours à un matériel spécifique (GPU NVIDIA CUDA) et des performances moins optimisées avec certaines méthodes de quantification.

Ollama en pratique

- Pourquoi les équipes le choisissent : Service à une seule machine sans friction.

- Ce que vous réglez : Très peu de choix de modèles et quelques drapeaux.

- Où il convient : Développement local, prototypes et production légère là où le trafic est faible.

Tableau de décision

Remarque : Les benchmarks sont utiles pour comparer les moteurs d'inférence LLM, car ils mettent en évidence des indicateurs de performance tels que le débit et la vitesse. Chaque moteur a ses propres limites en ce qui concerne les exigences matérielles et la prise en charge des modèles. Le MLC-LLM est un autre moteur d'inférence présentant un potentiel de faible latence et de vitesse de décodage élevée, mais il présente actuellement des limites telles que la nécessité de compiler des modèles, une quantification moins optimisée et des problèmes d'évolutivité.

Essayez Compute dès aujourd'hui

Sur Calculer, vLLM propose le choix de la région, des préréglages RTX 4090 ou multi-GPU, le protocole HTTPS par défaut et une facturation à la seconde.

Recommandations par cas d'utilisation

- Applications de chat interactives : VLLm ou TGI. Privilégiez vLLM pour une plus grande simultanéité. Une réponse rapide est cruciale pour l'expérience utilisateur, car les utilisateurs attendent des réponses immédiates et précises de la part du système.

- Backends RAG : VLLm pour le débit ; TGI si votre outillage est entièrement HF. Évaluez le débit et la qualité des réponses à l'aide d'un ensemble de données pertinent pour vous assurer que le backend répond à vos besoins.

- Tâches à très faible latence (instructions courtes, sorties courtes) : TensorRT‑LLM si votre modèle et votre matériel sont bien pris en charge. La latence au niveau des jetons est particulièrement importante pour ces cas d'utilisation.

- Assistants locaux et petits outils internes : Ollama. Concentrez-vous sur les réponses destinées aux utilisateurs et sur la facilité de déploiement.

Comment tester avant de vous engager

Les points de référence sont essentiels pour une comparaison équitable des différents moteurs, et l'inférence de base peut être utilisée comme base de comparaison.

- Choisissez un ensemble d'invites réaliste à l'aide d'un ensemble de données standardisé, tel que databricks-dolly-15k ou ShareGPT, et définissez des limites de sortie appropriées.

- Jetons de référence par seconde et vitesse de décodage en mesurant TTFT et jetons par seconde dans un contexte de concurrence croissante, en simulant plusieurs utilisateurs pour évaluer le débit et la latence.

- Surveillez la marge de manœuvre de la mémoire GPU et l'état du cache.

- Évaluez et comparez le coût pour 1 000 jetons en fonction de votre latence et de vos performances cibles.

- Essayez un exercice de panne (timeout) et un rechargement à chaud.

Considérations supplémentaires

Il ne suffit pas d'un moteur d'inférence pour déployer efficacement des LLM. La compilation des modèles est importante. La quantification influe sur la vitesse. Votre choix matériel (les GPU NVIDIA fonctionnent le mieux) détermine la vitesse d'exécution de votre modèle et la quantité de mémoire qu'il utilise. Le traitement par lots dynamique et le traitement par lots persistant sollicitent davantage votre processeur graphique. Ils augmentent le débit. Attention, les algorithmes accélèrent également l'exécution des grands modèles. Adaptez chaque élément aux besoins de votre déploiement. Tenez compte de ces facteurs. Ajustez votre configuration. Vous obtiendrez une inférence LLM rapide, évolutive et qui ne dépasse pas votre budget.

Meilleures pratiques en matière de déploiement

Vous tirerez le meilleur parti de votre déploiement LLM si vous suivez quelques pratiques clés. Commencez par ajuster la pondération des modèles et utilisez des fonctionnalités telles que le traitement par lots continu et l'inférence distribuée pour gérer correctement les demandes multiples. Choisissez le moteur d'inférence qui correspond à votre cas d'utilisation spécifique. Vous devrez trouver un équilibre entre la latence, le débit et l'utilisation de la mémoire. Surveillez les performances à l'aide des outils disponibles et recueillez des commentaires pour identifier les domaines à améliorer. Restez au fait des dernières avancées en matière de moteurs d'inférence et de LLMS. Cela vous permet de maintenir des performances élevées en matière de génération de texte et de vous adapter à l'évolution des besoins de production. En suivant ces directives, vous simplifierez votre processus de déploiement et vous vous assurerez que vos grands modèles linguistiques fournissent des résultats fiables, rapides et évolutifs.

Orientations futures

Les moteurs d'inférence LLM ne cessent de s'améliorer. De nouveaux outils tels que le parallélisme des tenseurs et les méthodes de quantification intelligentes aideront les modèles à s'exécuter plus rapidement tout en utilisant moins de mémoire. De plus en plus de moteurs sont conçus pour un matériel et des cas d'utilisation spécifiques. Cela signifie que vous pouvez ajuster les performances exactement là où vous en avez besoin. Alors que de plus en plus d'équipes souhaitent un déploiement efficace de LLM, vous devez vous tenir au courant de ces changements. Lorsque vous adoptez de nouvelles approches et de nouveaux outils, vous pouvez créer des modèles qui génèrent du texte plus rapidement et s'adaptent mieux. Votre travail reste compétitif lorsque vous savez ce qui est disponible et comment l'utiliser.

Bénéficiez des meilleurs moteurs d'inférence adaptés à vos besoins

Choisissez le moteur qui correspond à vos contraintes du moment et gardez la porte ouverte pour changer. Commencez simplement, mesurez honnêtement et optimisez là où les chiffres l'indiquent.

Essayez Compute dès aujourd'hui

Vous voulez démarrer rapidement ? Lancez un Point de terminaison vLLM sur ordinateur avec le matériel et la région de votre choix, puis pointez votre client OpenAI vers la nouvelle URL de base.

FAQ

Quel moteur est le plus rapide ?

Le terme « le plus rapide » dépend de votre modèle, de la longueur du contexte et du matériel. La vitesse de décodage est un indicateur clé lors de la comparaison des moteurs. TensorRT-LLM gagne souvent sur les configurations NVIDIA prises en charge, tandis que vLLM excelle en termes de simultanéité et de débit constant.

Qu'est-ce qui est le plus facile à exécuter en production ?

Ollama est plus facile avec une seule boîte. Pour les API réelles, vLLM propose le chemin le plus simple en raison de son serveur compatible OpenAI et de ses valeurs par défaut judicieuses. Les différentes bibliothèques offrent différents niveaux de facilité d'utilisation et de flexibilité de déploiement.

Puis-je changer plus tard ?

Oui Maintenez la stabilité de votre API client et intégrez les paramètres spécifiques au moteur côté serveur. Prévoyez les différences entre les noms des modèles et les bizarreries en matière de streaming. Soyez conscient des limites des différentes bibliothèques, telles que les dépendances matérielles, les exigences de compilation des modèles et la prise en charge de la quantification, qui peuvent affecter la commutation.

Comment puis-je établir une comparaison équitable ?

Utilisez des repères et des outils d'analyse comparative pour évaluer les performances. Simulez plusieurs utilisateurs et utilisez un ensemble de données standardisé (tel que databricks-dolly-15k ou ShareGPT) pour corriger les invites. Limitez les jetons, testez plusieurs simultanités et suivez le TTFT/TPS. Évaluez la vitesse de décodage, le débit des jetons et la latence. Utilisez la même région et le même réseau.